De l’intelligence artificielle à l’éthique des machines

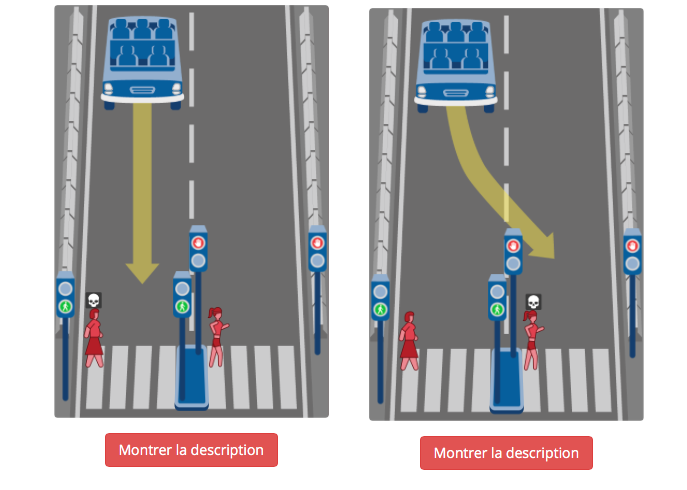

Les enfants nés cette année ne conduiront probablement jamais de voiture. Les voitures autonomes développées par Google ou Toyota seront sans doute à l’œuvre bientôt, et les assurances ne prendront plus le risque de couvrir les conducteurs humains. Faut-il y voir la perte de notre liberté et de notre autonomie ? Ou se réjouir d’une future réduction drastique du nombre de morts sur les routes ? Cet exemple, extrêmement médiatisé, pose également de cruciales questions éthiques. Si la voiture autonome, à pleine vitesse, se trouve soudainement face à un piéton, quel comportement doit-elle adopter ? Se détourner vivement, au risque de s’écraser contre un obstacle solide et de tuer les passagers de la voiture ? Ou continuer sa route, et tuer l’innocent piéton ? Donneriez-vous la même réponse si le piéton traversait alors que le feu était vert pour les voitures ? Si le piéton est un vieil homme de 90 ans et la passagère une jeune femme enceinte de jumeaux ? Une intelligence artificielle peut choisir en une fraction de seconde qui sera la victime : quelle éthique voulons-nous lui donner ?

Sur la page Moral Machines du MIT, vous pourrez donner vos préférences éthiques face à de nombreuses situations analogues, et même construire vous-même, avec perversité, le dilemme le plus cornélien possible. Un article de Jean-François Bonnefon, Azim Shariff et Iyad Rahwan, paru dans la revue Science en Juin 2016, a le mérite de mettre les constructeurs de voitures face à leurs futures contractions. Les auteurs ont demandé à près de 2000 citoyens de choisir, au cas où un accident de voiture autonome était inévitable, quelle devait être la victime : le passant ou le passager ? La plupart des personnes interrogées sauvent le passant et tuent le passager – coupable d’avoir utilisé la voiture. En revanche, ces mêmes personnes se déclarent peu intéressées d’acheter une voiture qui serait programmées pour tuer ses propres passagers en cas de risque pour les passants… Dilemme pour les constructeurs et les législateurs : faire une voiture éthique quitte à diminuer les ventes ? Ou maximiser les ventes au mépris des piétons ?

C’est un champ d’études assez jeune, à la croisée de l’éthique et de l’intelligence artificielle (IA), que m’a fait récemment découvrir Grégory Bonnet, du laboratoire GREYC, lors de sa conférence au Dôme à Caen à l’occasion du festival Living Lab. Appelé Machine Ethics et né durant les années 2000, ce champ s’intéresse aux règles éthiques que nous souhaitons donner aux intelligences artificielles autonomes qui nous entourent. Le questionnement existe depuis bien plus longtemps, et tous les amoureux de science-fiction se souviennent des trois lois de la robotique d’Isaac Asimov, dessinant les fondements de l’éthique des machines à travers ses nouvelles du Cycle des Robots. Aujourd’hui, le sujet est bel et bien actuel : les machines savent apprendre par des algorithmes de plus en plus efficaces, et cette généralisation de l’apprentissage machine pose de nouvelles questions, puisque les machines adoptent alors un comportement appris progressivement par essai/erreur. Un choix non éthique, voire criminel, pourrait donc être pris par l’IA sans que personne ne l’ait spécifiquement programmé pour. Bill Gates, Elon Musk ou Stephen Hawking s’étaient d’ailleurs émus de ce problème, nous mettant en garde contre le développement des armes autonomes – véritable risque pour notre espèce. À l’inverse, le chercheur Ronald Arkin du Georgia Institute of Technology in Atlanta ne s’oppose pas au développement des armes autonomes, mais développe des « gouverneurs éthiques », programmes qui régulent le comportement de ces armes sur le champ de bataille. Notons toutefois que les recherches d’Arkin ont été en grande partie financées par le département de la Défense aux Etats-Unis… Sans même se projeter dans le futur, il serait sans doute bon de se questionner sur l’éthique de certains programmes informatiques boursiers qui maximisent leurs profits, quitte à adopter des choix fort contestables.

Il faudra donc, tôt ou tard, ajouter une programmation éthique à nos machines. Mais alors quelle éthique choisir ? L’utilitarisme de Bentham ou l’impératif catégorique de Kant ? Plus prosaïquement, quels choix feront les robots avec lesquels nous serons amenés à vivre (voir à ce sujet l’exposition Human Need Not Apply de la Science Gallery) ? De plus en plus autonomes, face à une complexité grandissante, ces robots auront un impact direct sur les vies humaines en agissant sur les champs de batailles, les marchés boursiers, les décisions judiciaires ou les orientations politiques. Suite à l’élection de Donald Trump, Facebook s’est engagé à travailler sur son intelligence artificielle pour lutter contre les fausses informations répandues par des groupes politiques peu scrupuleux. La mise en place d’une éthique des machines a déjà commencé, il ne reste plus qu’à l’extraire des officines des entreprises technologiques pour l’amener dans la sphère publique, pour que les citoyens s’emparent de la question et participent à un débat nécessaire. Les lieux de culture, d’art contemporain, de débat citoyen, de médiation scientifique et technique ont aujourd’hui accès à une large palette d’outils et d’approches, tels que les jeux de discussion ou la démarche Living Lab, pour susciter débats et réflexions.

Gardez le contact

Recevez notre newsletter sur les interactions entre arts&sciences, innovation et société. Juste un email par mois, avec de vrais morceaux de nous dedans.